當人們談論互聯網大數據時,常常會聯想到海量、爆炸、無窮無盡等詞匯。這些抽象的形容詞往往難以真正描繪其龐大尺度。互聯網的大數據規模,實際上已經遠遠超出了普通人的想象力邊界,而支撐其運轉的互聯網數據服務,則構成了現代社會不可或缺的數字基石。

1. 數據洪流:每秒都在刷新認知的體量

互聯網大數據究竟有多大?不妨先看幾個直觀的數據:

據統計,全球互聯網用戶每天產生約2.5萬億字節的數據。這相當于每天產出約250萬部高清電影,如果將這些電影連續播放,需要超過5萬年才能看完。每分鐘,YouTube用戶上傳超過500小時的視頻,Netflix用戶觀看超過2.5萬小時的節目;每秒鐘,谷歌處理超過10萬次搜索查詢。這些實時生成的數據流,僅僅是冰山一角。

從存儲角度看,全球數據總量正以指數級速度增長。根據國際數據公司(IDC)的預測,到2025年,全球數據圈(指每年創建、捕獲、復制和消費的數據總量)預計將達到175 ZB(澤字節)。1 ZB相當于1萬億GB,而175 ZB的數據量,如果存儲在常見的DVD光盤上,這些光盤疊起來的高度足以從地球往返月球近23次。

2. 數據來源:無處不在的生成節點

互聯網大數據的龐大,源于其來源的廣泛性和多樣性:

- 社交網絡與通訊:微信、Facebook、Twitter等平臺每天產生數百億條消息、圖片和視頻。

- 物聯網設備:智能家居、工業傳感器、車載系統等數十億設備持續采集環境、行為和狀態數據。

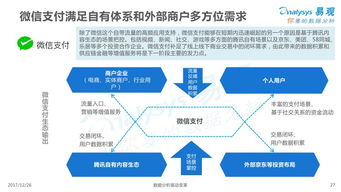

- 商業與交易:電子商務、在線支付、物流追蹤每筆交易都生成多維度數據。

- 科學研究:天文觀測、基因測序、粒子對撞實驗等產生PB級乃至EB級數據集。

- 多媒體內容:短視頻、直播、在線游戲等富媒體應用是數據增長的主要驅動力之一。

這些數據不僅體量巨大,而且往往具有高速(Velocity)、多樣(Variety)、實時(Real-time)等特征,對處理技術提出了極致挑戰。

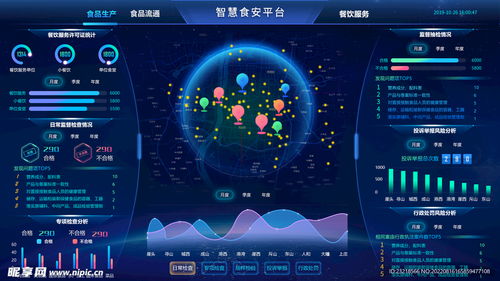

3. 互聯網數據服務:駕馭數據洪流的“方舟”

面對如此浩瀚的數據海洋,互聯網數據服務應運而生,成為組織、處理、分析并賦能應用的關鍵基礎設施。主要包括:

- 數據存儲與管理:

分布式文件系統(如HDFS)、NoSQL數據庫(如MongoDB)、云存儲服務(如AWS S3)等,提供了可擴展、高可用的數據存貯方案。對象存儲服務已能支持EB級數據池,滿足海量非結構化數據的存儲需求。

- 數據處理與計算:

以Hadoop、Spark為代表的分布式計算框架,允許在成千上萬臺服務器上并行處理PB級數據。流處理引擎(如Flink、Kafka Streams)則能對高速數據流進行實時分析與響應,延遲可低至毫秒級。

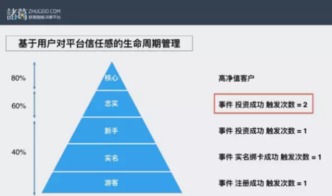

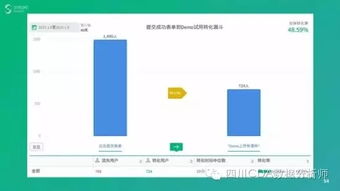

- 數據分析與智能:

數據倉庫、OLAP系統及AI平臺,使企業能從數據中挖掘趨勢、預測行為。例如,推薦系統每天處理萬億級特征,優化用戶體驗;城市大腦實時分析數十萬路視頻流,提升治理效率。

- 數據服務與API經濟:

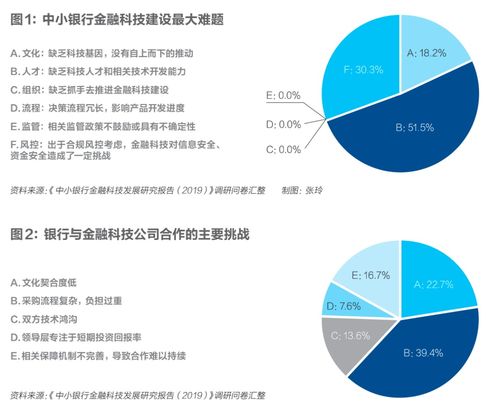

許多公司將數據能力封裝為服務,通過API開放。例如,地理位置服務、金融風控模型、圖像識別接口等,讓開發者無需從頭構建數據基礎設施,即可集成強大功能。

4. 未來展望:從“大”到“智能”的演進

互聯網大數據仍在加速膨脹,而數據服務的發展焦點已逐漸從單純存儲處理,轉向數據價值深挖與合規高效利用:

- 邊緣計算與云邊協同:將計算推向數據源頭,減少延遲與帶寬壓力,滿足物聯網、自動駕駛等場景需求。

- 隱私計算與數據安全:在數據不出域的前提下,通過聯邦學習、多方安全計算等技術實現聯合建模,平衡價值挖掘與隱私保護。

- AI驅動的數據自治:利用機器學習自動完成數據分類、質量檢測、異常監測,降低管理成本。

- 可持續發展:優化數據中心能效,采用綠色能源,應對數據增長帶來的巨大能耗挑戰。

###

互聯網的大數據,已不僅是一個技術概念,更是如同新時代的“自然資源”,其規模之大、增長之快,持續挑戰著人類的技術極限與認知邊界。而互聯網數據服務,則是我們駕馭這片數字海洋的航船與羅盤。它讓無序的數據洪流轉化為有序的信息,讓潛在的洞察顯現為現實的價值。在隨著量子計算、神經形態計算等新技術的融合,我們或許能以今天難以想象的方式,探索并利用那些“完全超出想象力”的數據宇宙。理解其宏大,善用其服務,正是數字時代賦予我們的關鍵課題。